A medida que las empresas usan cada vez más IA para verificar identidades y prevenir fraudes, se enfrentan a nuevas amenazas: vídeos deepfake que burlan el reconocimiento facial, voces sintéticas que esquivan controles biométricos, y sofisticados ataques de repetición o inyección. Las comprobaciones tradicionales de ciberseguridad ya no son suficientes, porque ahora los atacantes apuntan directamente a las vulnerabilidades de los modelos de IA.

Para combatir estos riesgos se necesitan equipos especializados que simulen ataques avanzados específicos para IA. En Mitek, creamos ese equipo: nuestro “Equipo Púrpura”, formado por hackers éticos dedicados a poner a prueba nuestras soluciones de verificación de identidad. Este equipo identifica vulnerabilidades en reconocimiento facial, voz y autenticidad documental simulando ataques reales basados en IA.

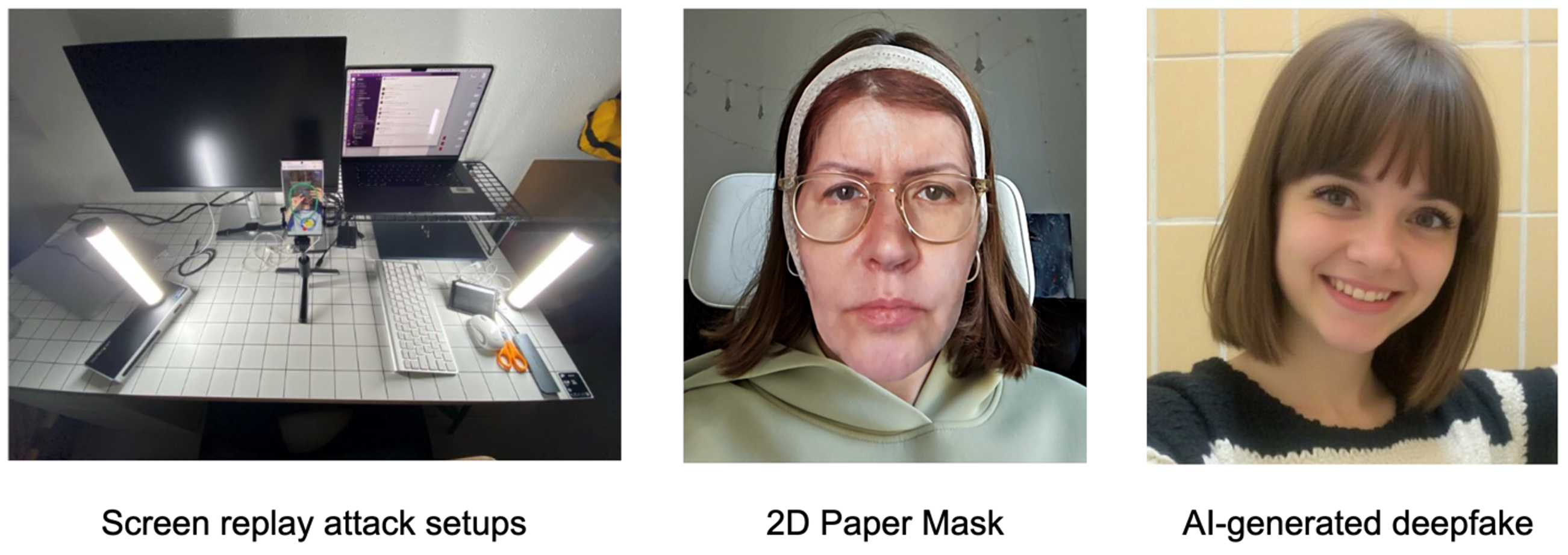

El Equipo Púrpura nació de una competición interna de hacking ético que mostró algunas de las simulaciones de fraude más creativas. Son cazadores profesionales de vulnerabilidades en IA que no implementan defensas ni responden a incidentes, sino que atacan agresivamente con técnicas punteras, como máscaras 3D hiperrealistas, imágenes deepfake generadas con GAN, clonación de voz o falsificación documental. Sus hallazgos se integran rápidamente en el desarrollo para mejorar continuamente nuestros productos.

Su eficacia ha sido reconocida externamente consiguiendo un Gold Globee Award en Ciberseguridad por sus innovaciones y rigor en sus pruebas. Gracias a ellos, la tecnología de detección de fraude por IA de Mitek están entre las mejores del sector.

Más allá del desarrollo tradicional: la gobernanza del modelo de IA

El ciclo de vida del desarrollo de IA difiere del software convencional, pues los riesgos no solo vienen del código, sino también de los datos y el comportamiento del modelo (sesgos, deriva, ataques adversarios). Por eso, la seguridad debe ser continua y rigurosa durante toda la vida del modelo.

Los Equipos Púrpura desempeñan un papel clave en la gobernanza del modelo, realizando pruebas adversarias independientes y validaciones objetivas, distintas a las de los desarrolladores originales. Utilizan datasets de prueba diseñados para desafiar el modelo en condiciones extremas y detectar vulnerabilidades o sesgos tempranos.

Normas internacionales como la ISO/IEC 23894:2023 y el Marco de Gestión de Riesgos de IA de NIST recomiendan esta validación continua y pruebas adversarias como mejores prácticas para garantizar sistemas seguros y resilientes. Así, los Equipos Púrpura actúan como una tercera línea de defensa, asegurando que los modelos no solo se testen antes del lanzamiento, sino que se evalúen constantemente durante su operativa real.

Robustez adversaria (adversarial robustness): haciendo frente a amenazas específicas de la IA

¿Por qué los Equipos Púrpura son esenciales? Porque hacen frente a amenazas específicas que los equipos tradicionales no suelen cubrir:

-

Deepfakes faciales y ataques de presentación: imágenes, vídeos o voces generadas por IA pueden engañar a los sistemas biométricos. El Equipo Púrpura prueba nuestros modelos con las técnicas de deepfake más avanzadas para garantizar que detecten impostores y eviten fraudes.

-

Pruebas de detección de vida en documentos: simulan la creación de documentos falsos con plantillas, impresoras especializadas y laminados, además de ataques de reproducción en pantalla, para asegurar que el sistema distingue documentos auténticos de falsos.

Simulación de ataques de inyección digital en KYC: replican ataques que manipulan o inyectan contenido falso en los flujos de verificación usando cámaras virtuales, hooking de APIs y emuladores, asegurando que los sistemas detecten intentos de manipulación digital.

Gracias a su ágil enfoque y a su proactiva mentalidad, el Equipo Púrpura puede adaptarse rápidamente a nuevas amenazas —hoy deepfakes, mañana ataques por inyección de prompts o envenenamiento de datos— consiguiendo que estemos siempre un paso por delante.

Crear un Equipo Púrpura desde cero: lecciones clave

Los Equipos Púrpura son los héroes anónimos para el despliegue seguro de la IA. Mitek ha demostrado que invertir en ellos da frutos en forma de productos resistentes y reputación, aunque requiere compromiso cultural y operativo. Lo que hicimos bien:

- Empezamos pronto: no esperamos a que ocurriera un incidente grave para integrar la seguridad en nuestros proyectos de IA. Desde las primeras etapas formamos un Equipo Púrpura pequeño pero con una misión tanto ofensiva como defensiva, que detectaba problemas en la arquitectura y los datos antes de que arraigaran.

- Contratamos y formamos talento híbrido: buscamos perfiles con habilidades en seguridad ofensiva y conocimientos en IA/ML, y en algunos casos combinamos a nuestros científicos de datos con hackers éticos experimentados. Fomentamos que el equipo de seguridad aprenda técnicas adversarias de ML y que los ingenieros de IA adopten una mentalidad orientada a la seguridad. Esta colaboración cruzada fortaleció al equipo.

- Integración en la gobernanza del modelo: el Equipo Púrpura se incorporó formalmente a nuestro marco de gobernanza de IA, realizando validaciones independientes para evitar conflictos de interés. Sus hallazgos se usaron para decidir si lanzar o no un modelo, y contaron con recursos para crear datos de prueba propios y realizar simulaciones de ataque, con apoyo de la dirección, que priorizó la confianza a largo plazo sobre beneficios rápidos.

- Evolución continua: las pruebas del Equipo Púrpura pasaron a ser recurrentes. Las amenazas en IA cambian rápidamente, así que establecimos ciclos de pruebas, aprendizaje y mejora.

- Cultura de seguridad compartida: finalmente, el Equipo Púrpura se ha convertido en el embajador de la seguridad en IA en toda la organización. Su trabajo educaba a desarrolladores, gestores y líderes sobre riesgos y defensas en IA. Ver los ataques creativos que diseñaba el equipo motivaba a los científicos de datos a construir modelos seguros desde el principio.

Crear un Equipo Púrpura en una fase temprana y encomendarles la constante protección de la IA prepara a cualquier empresa para hacer frente al riesgo real en IA. En un mundo donde cada vez proliferan más deepfakes, identidades sintéticas y ataques inteligentes, esta fusión de rojo y azul es la mejor apuesta para ir siempre un paso por delante.

References:

1, 2: ISO/IEC 23894 – A new standard for risk management of AI - AI Standards Hub, ISO/IEC 23894 – A new standard for risk management of AI - AI Standards Hub

3: NIST AI Risk Management Framework (AI RMF) - Palo Alto Networks

4: NIST AI Risk Management Framework (AI RMF) - Palo Alto Networks

5: NIST AI Risk Management Framework (AI RMF) - Palo Alto Networks

6: Generative AI red teaming: Tips and techniques for putting LLMs to the test | CSO Online