La tecnología biométrica en sí misma no está inherentemente sesgada; es el diseño de la tecnología biométrica lo que puede introducir discriminación.

Los sistemas biométricos analizan las características fisiológicas o de comportamiento de una persona con el objetivo de verificar y autentificar la identidad. Esto, a menudo, se lleva a cabo a través de la tecnología de reconocimiento facial y de huellas dactilares basada en el aprendizaje automático y la IA, todo ello impulsado por algoritmos. El sesgo ocurre cuando el algoritmo opera de manera discriminatoria, lo cual, a menudo, se deriva de cómo se construye, diseña o prueba el algoritmo.

Hay implicaciones en el mundo real a consecuencia de los algoritmos sesgados. Los rostros afroamericanos y asiáticos tienen de 10 a 100 veces más probabilidades de ser identificadas erróneamente por el reconocimiento facial que los rostros caucásicos. Según un estudio de 189 algoritmos, las tecnologías de reconocimiento facial son las menos precisas en las mujeres de color. También está la cuestión de la sobrerrepresentación en los conjuntos de datos. Según el Instituto Brookings, los investigadores de la Facultad de Derecho de Georgetown descubrieron que más de 115 millones de adultos estadounidenses están en redes de reconocimiento facial utilizadas por las fuerzas del orden, y que los afroamericanos tenían más probabilidades de ser señalados debido a su sobrerrepresentación en las bases de datos de fotos de rostros. En consecuencia, los rostros afroamericanos tenían más oportunidades de ser falsamente emparejados, lo que producía un efecto sesgado.

Si bien sabemos que el sesgo biométrico es incorrecto, prevenirlo no es tan simple. El primer paso para combatir el sesgo es comprender cómo sucede.

El sesgo biométrico es el resultado de dos componentes: la introducción de datos sesgados en el sistema y el análisis sesgado de los datos. Los algoritmos se entrenan utilizando conjuntos de datos. Cuando los conjuntos de datos se inclinan hacia ciertas características, el modelo de aprendizaje automático se centra más en esas características. Esto se conoce como sobreajuste y hace que el sistema sea menos capaz de identificar patrones que se encuentran fuera de esas características. Por lo tanto, los datos no están realmente sesgados hacia una determinada raza o edad, sino que son menos capaces de identificar con precisión la demografía periférica basada en el conjunto de datos original.

El segundo componente del sesgo biométrico, la evaluación de los datos, se refiere a cómo se identifican los datos en sí. Según Towards Data Science, existen múltiples tipos de sesgos cognitivos humanos que pueden afectar negativamente a la identificación de datos. Como ocurre con el sesgo de confirmación, donde solo interpretamos los datos de manera que confirmen nuestras ideas preconcebidas.

Hay implicaciones en el mundo real a consecuencia tanto del uso de conjuntos de datos que no incluyen diversos rostros, como del análisis sesgado de los datos. En 2020, un hombre de Michigan fue arrestado por un crimen que no cometió. ¿Por qué? Porque el sistema de reconocimiento facial biométrico dio como resultado una coincidencia no concluyente. El oficial de policía interpretó esto como una coincidencia definitiva, y una causa de arresto. En este caso, tanto la falta de precisión del algoritmo como el sesgo humano desembocaron en la decisión del oficial.

Haz clic aquí para obtener más información de Steve Ritter sobre el sesgo biométrico

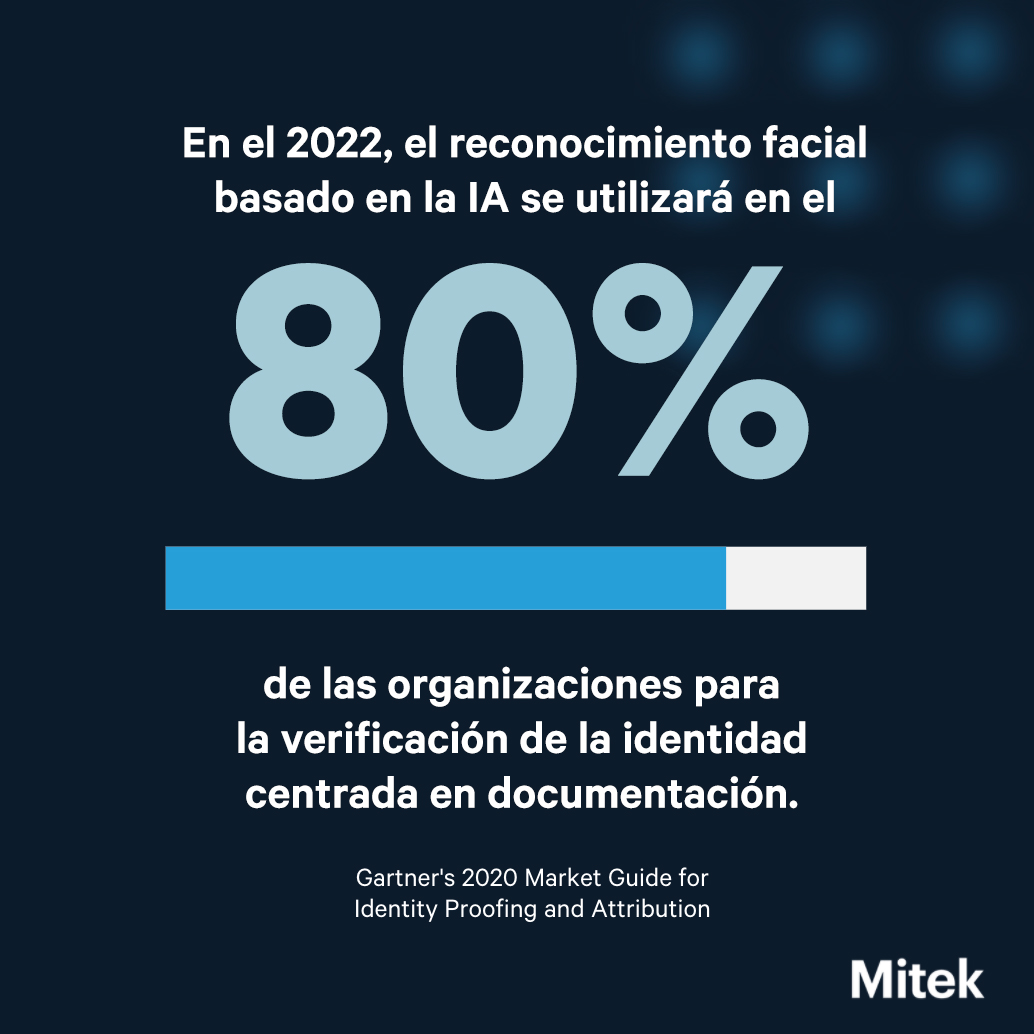

Vivimos en una sociedad digital y nuestro mundo digital debe ser tan equitativo como nuestro mundo físico, si no más. El asunto es de vital importancia porque, según Gartner, para 2022, el reconocimiento facial basado en la IA se utilizará en el 80 % de las organizaciones para la verificación de la identidad centrada en documentación, a la hora de realizar el onboarding de nuevos clientes. A medida que nos acercamos rápidamente al 2022, es crucial que nos preocupemos por reducir el sesgo biométrico. En mi opinión, se trata de libertad. Nuestro software juega un papel clave en la decisión de quién es libre de acceder a los servicios esenciales. Así que sí, creo que todas las personas tienen el derecho intrínseco de acceder a los servicios digitales de una manera imparcial.

¿Qué podemos hacer respecto al sesgo biométrico? Tenemos un largo camino por recorrer, pero hay múltiples soluciones en las que podemos trabajar para disminuir el sesgo biométrico.

Primera solución: Normas de ensayo

Primero, necesitamos una forma de evaluar el sesgo biométrico. Actualmente, no existe una medición estandarizada de terceros para evaluar el sesgo demográfico en las tecnologías biométricas.

La industria necesita una forma de evaluar la equidad y la inclusión de las tecnologías biométricas. Esto daría a los proveedores de servicios una forma de garantizar que su solución sea equitativa, independientemente de si se construyó internamente o se basó en tecnología de terceros de un proveedor. Este punto de referencia proporcionaría al público la información que necesita para seleccionar un proveedor de servicios que sea más equitativo.

Segunda solución: Directrices globales de IA

Determinar «lo que es correcto» va más allá de crear puntos de referencia de precisión, también necesitamos crear pautas éticas. Hasta que no haya pautas éticas para el uso de esta tecnología, no hay forma de entender lo que es «correcto».

Las directrices éticas de IA servirían para solidificar los derechos y libertades de las personas que utilizan o están sujetas a tecnologías biométricas basadas en datos. Hasta que no definamos qué es y qué no es un uso ético de la tecnología biométrica, no existe una métrica o punto de referencia para medir la calidad de la tecnología.

Afortunadamente, para muchos países desarrollados, se está debatiendo cómo debería ser. En Estados Unidos, la Administración Biden está en conversaciones para crear una Declaración de Derechos de IA. El Reino Unido ha publicado recientemente una Estrategia Nacional de IA a 10 años. Actualmente, la UE está trabajando a través de la propuesta de la Ley de IA de la UE. Sin embargo, tenemos que hacer algo más que hablar teóricamente sobre la IA y sus implicaciones. Tenemos que actuar a escala mundial.

Nuestra tecnología debe trabajar para nosotros, no contra nosotros. En este momento, sabemos que existe un sesgo en la tecnología que todos usamos todos los días. Sin embargo, a medida que miramos hacia el futuro, ante la posibilidad de una forma de estandarizar las pruebas para el sesgo demográfico y las formas en que podemos decidir sobre las pautas éticas, las posibilidades se abren. Una vez que estemos en un mundo en el que seamos capaces de eliminar el sesgo de nuestra tecnología y algoritmos, ¿qué será lo próximo para esta tecnología? ¿Cómo podemos utilizar la biometría para hacer un mundo más equitativo?

Eliminación del sesgo biométrico: Cómo hacer que tus algoritmos funcionen, por Stephen Ritter, CTO en Mitek